Bộ Thông tin và Truyền thông (TT&TT) vừa phát thông tin cảnh báo liên quan tới deepfake - công nghệ trí tuệ nhân tạo giả mạo hình ảnh, giọng nói nhằm mục đích xấu, chiếm đoạt tài sản. Theo đánh giá của Bộ T&TT, thủ đoạn tinh vi này đang là mối lo ngại với rất nhiều người dùng Internet trong thời gian vừa qua.

Theo định nghĩa dễ hiểu từ hãng bảo mật Kaspersky, deepfake là một từ ghép của "deep" trong "deep learning" (học sâu) và "fake" (giả mạo). Deep learning là phương pháp AI tiên tiến sử dụng nhiều lớp thuật toán machine learning (máy học) để trích xuất dần các tính năng cao cấp hơn từ dữ liệu đầu vào.

"Nó có khả năng học hỏi từ dữ liệu phi cấu trúc, chẳng hạn như khuôn mặt con người, chuyển động vật lý và giọng nói.chẳng hạn như khuôn mặt người. Nó thậm chí có thể thu thập dữ liệu về các chuyển động vật lý của con người.

Các dữ liệu này sau đó sẽ được xử lý để tạo ra video deepfake thông qua mạng GAN (Generative Adversarial Network). Mạng lưới này liên tục kiểm tra các hình ảnh tạo ra theo thiết lập từ trước, nhờ đó hình ảnh sẽ ngày càng thuyết phục hơn. Và Deepfake trở thành mối đe dọa thật sự", Kaspersky cảnh báo.

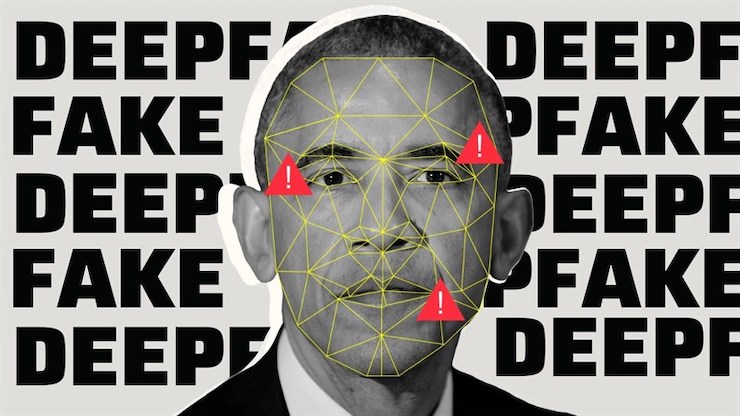

Cựu tổng thống Mỹ Barack Obama từng là nạn nhân của deepfake.

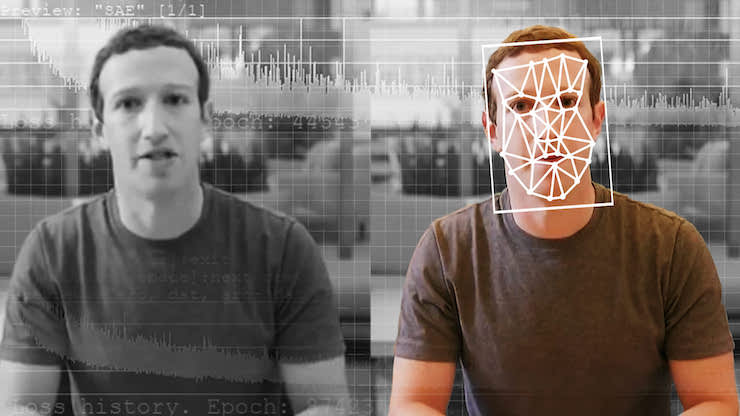

CEO Facebook Mark Zuckerberg cũng từng bị làm giả video, do công nghệ deepfake tạo ra.

Kaspersky cho biết, các video deepfake đã được dùng cho mục đích chính trị cũng như trả thù cá nhân. Và gần đây, chúng được sử dụng thường xuyên cho mục đích tống tiền và lừa đảo.

Dù vậy, theo Kaspersky, deepfake vẫn trong giai đoạn mà người xem có thể nhận biết được nếu chú ý vào các đặc điểm: Chuyển động bị giật, thay đổi ánh sáng từ khung hình này sang khung hình khác, thay đổi tông màu da, chớp mắt một cách khác thường hoặc hoàn toàn không chớp mắt, khẩu hình và âm thanh không khớp, và các lỗi xuất hiện trong hình ảnh.

Trong khi đó, theo Bộ TT&TT, rất khó để có thể giải thích cụ thể về phương thức hoạt động của deepfake theo hướng kỹ thuật. Nhưng có thể hiểu đơn giản rằng, deepfake với khả năng học hỏi dữ liệu khuôn mặt, hình ảnh và cả giọng nói của con người, nó sẽ khiến khuôn mặt của một người A được gắn lên cơ thể của người B rất giống thật, đến mức rất khó để nhận biết nếu chỉ đơn giản là nhìn lướt qua.

Trước thực trạng này, hãng bảo mật Kaspersky khuyến nghị người dùng cuối:

- Sao lưu thường xuyên để bảo vệ dữ liệu trước ransomware và người dùng có thể khôi phục lại các dữ liệu bị tổn hại.

- Sử dụng nhiều mật khẩu mạnh, khác nhau cho các tài khoản khác nhau. Bởi vì nếu khi tài khoản Facebook bị xâm nhập thì khả năng cao các tài khoản khác cũng sẽ gặp trường hợp tương tự.

- Sử dụng giải pháp bảo mật để bảo vệ mạng gia đình, máy tính và điện thoại thông minh trước mối đe dọa mạng. Giải pháp sẽ cung cấp phần mềm diệt virus, VPN để ngăn kết nối Wi-Fi bị hack và bảo vệ webcam.

Đối với doanh nghiệp, Kaspersky khuyến cáo:

- Đảm bảo nhân viên và gia đình hiểu về deepfake và các thách thức nó đặt ra.

- Trang bị cho bản thân và người xung quanh biết cách nhận biết deepfake.

- Đảm bảo hiểu về truyền thông và sử dụng nguồn thông tin xác thực.

""Trust but verify" – tin nhưng cũng cần xác thực. Thái độ hoài nghi đối với thư thoại và video sẽ không đảm bảo 100% bạn sẽ không bao giờ bị lừa đảo, nhưng nó có thể giúp tránh được nhiều cạm bẫy", Kasperksy nhắn gửi.

Bộ TT&TT thì đưa ra những lời khuyên sau đây dành cho người dùng Internet:

- Tin tưởng nhưng vẫn phải xác minh: Nếu nhận được một đoạn tin nhắn thoại đặc biệt là các tin nhắn hướng đến mục đích vay tiền hoặc mượn tài sản cá nhân của bạn. Dù cho giọng nói nghe rất quen thuộc và cực kỳ giống thật, tốt nhất bạn vẫn nên gọi lại bằng số điện thoại mà bạn biết là chính xác để xác minh rằng đồng nghiệp, người thân đó của bạn đã thực sự gửi yêu cầu bằng tin nhắn thoại.

- Đừng vội truy cập bất kỳ đường link nào: Khi được người thân gửi cho một đường link với những cấu trúc lạ, đừng vội vàng nhấp vào đường link/nút đó. Rất có thể đó là một cái bẫy được đưa ra để kẻ lừa đảo có thể chiếm đoạt tài khoản trực tuyến của bạn. Hãy tìm cách xác minh lại với người đã gửi tin nhắn cho bạn.

- Hãy chú ý vào những điều nhỏ nhất: Nếu nhận được một cuộc gọi chuyển tiền hoặc video call với nội dung chuyển tiền, dù là người thân thiết, bạn vẫn hãy xem kỹ số điện thoại, email hoặc tài khoản có trùng hợp với người đang thực hiện yêu cầu hay không. Thông thường các đối tượng sẽ yêu cầu chuyển tiền sang một tài khoản bên thứ ba hoặc sang một tài khoản có tên gần tương tự.

- Hạn chế quyền truy cập vào giọng nói và hình ảnh của bạn: Như chúng ta đã biết, để có thể tạo ra hình ảnh và âm thanh giả những kẻ lừa đảo sẽ cần các bản ghi âm, hình ảnh hoặc cảnh quay của bạn để tạo ra những sản phẩm giả. Để ngăn chặn việc dữ liệu hình ảnh, âm thanh của bạn bị sao chép, hãy hạn chế sự hiện diện của bạn trên mạng xã hội hoặc đặt tài khoản của bạn ở chế độ riêng tư, chỉ chấp nhận yêu cầu từ những người bạn tin tưởng.