Kể từ khi thành lập ý tưởng về trí thông minh nhân tạo trong những năm 1950, game đã là một cách hiệu quả để đo lường năng lực của AI. Chúng đặc biệt thuận tiện trong việc kiểm tra năng lực của các kỹ thuật AI mới, bởi bạn có thể định lượng hiệu suất của AI với điểm số và thắng-thua và so sánh nó với con người hoặc AI khác.

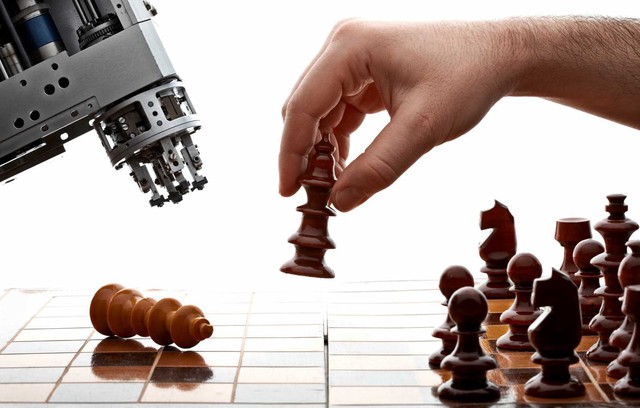

Trò chơi đầu tiên mà các nhà nghiên cứu cố gắng để làm chủ thông qua AI là cờ vua, là trò mà trong những ngày đầu được coi là thử nghiệm tối thượng của tiến bộ trong lĩnh vực này. Năm 1996, Deep Blue của IBM là máy tính đầu tiên đánh bại một nhà vô địch thế giới (Garry Kasparov) trong môn cờ vua. AI đằng sau Deep Blue sử dụng phương pháp brute-force để phân tích hàng triệu chuỗi lệnh trước khi thực hiện di chuyển.

Tuy nhiên, phương pháp của Deep Blue để làm chủ môn cờ không còn hiệu quả để giải quyết các trò chơi phức tạp hơn. Theo tiêu chuẩn ngày nay, phương pháp đó được xem là thô. Khi Deep Blue đánh bại kiện tướng Kasparov, đã có một nhà khoa học nhận xét rằng sẽ mất thêm một trăm năm nữa để AI có thể chinh phục môn Cờ Vây của Trung Quốc, nổi tiếng với lượng đường đi nhiều hơn cả số lượng nguyên tử trong vũ trụ.

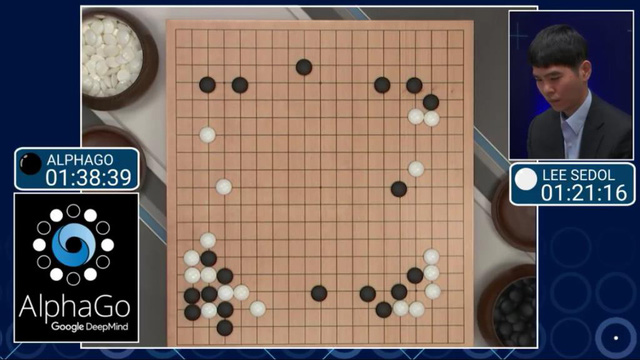

Nhưng trong năm 2016, các nhà nghiên cứu DeepMind - công ty AI thuộc sở hữu của Google - đã tạo ra AlphaGo, AI này đã đánh bại Lee Sedol - nhà vô địch Cờ Vây thế giới - với tỉ số 4-1 trong một cuộc thi năm ván đấu. AlphaGo thay thế phương pháp brute-force của Deep Blue bằng deep learning, một kỹ thuật AI hoạt động theo cách tương tự như cách thức hoạt động của bộ não con người. Thay vì kiểm tra mọi kết hợp có thể, AlphaGo đã kiểm tra cách con người chơi Cờ Vây, sau đó cố gắng tìm ra và nhân rộng các mẫu gameplay thành công.

Các nhà nghiên cứu của DeepMind sau đó đã tạo ra AlphaGo Zero, một phiên bản cải tiến của AlphaGo với phương pháp reinforcement learning được sử dụng, một phương pháp không yêu cầu có đầu vào của người. AlphaGo Zero đã được dạy các quy tắc cơ bản của môn Cờ Vây và được học cách chơi game bằng cách tự chống lại chính nó vô số lần. Và AlphaGo Zero đã đánh bại người tiền nhiệm của nó.

Tuy nhiên, các trò chơi trên có những hạn chế nhất định. Đầu tiên, chúng được chơi dựa theo lượt, có nghĩa là AI không bị căng thẳng để đưa ra quyết định trong một môi trường thay đổi liên tục. Thứ hai, AI có quyền truy cập vào tất cả các thông tin trong môi trường và không phải dự đoán hoặc chấp nhận rủi ro dựa trên các yếu tố không xác định.

Xem xét về điều này, một AI được gọi là Libratus đã thực hiện bước đột phá tiếp theo trong nghiên cứu trí tuệ nhân tạo với việc đánh bại những người chơi Texas Hold 'Em poker giỏi nhất. Được phát triển bởi các nhà nghiên cứu tại Carnegie Mellon, Libratus cho thấy AI có thể cạnh tranh với con người trong những tình huống mà nó chỉ có thể truy cập thông tin một phần. Libratus sử dụng một số kỹ thuật AI để học poker và cải thiện lối chơi của nó khi nó kiểm tra chiến thuật của các đối thủ con người.

Game thời gian thực là ranh giới tiếp theo cho AI và thực tế là OpenAI không phải là tổ chức duy nhất tham gia vào lĩnh vực này. Facebook đã thử nghiệm dạy AI chơi game chiến lược thời gian thực StarCraft, và DeepMind đã phát triển một AI có thể chơi trò chơi bắn súng góc nhìn thứ nhất Quake III. Mỗi trò chơi đều mang các thách thức riêng, nhưng mẫu số chung là tất cả chúng đều thử thách AI với môi trường mà chúng phải đưa ra quyết định trong thời gian thực và thông tin không đầy đủ. Hơn nữa, chúng cung cấp cho AI một đấu trường, nơi AI có thể kiểm tra sức mạnh của nó trong việc chống lại một nhóm đối thủ và tìm hiểu tinh thần đồng đội.

Hiện tại, không ai phát triển AI chỉ nhằm để đánh bại game thủ chuyên nghiệp. Nhưng thực tế là AI đang cạnh tranh với con người ở những trò chơi phức tạp để cho thấy chúng phát triển đến mức nào.