Vào ngày 5/8 vừa qua, Apple đã công bố 3 nỗ lực mới để bảo vệ trẻ em khi dùng iPhone, iPad và Mac. Cụ thể, động thái này bao gồm các tính năng bảo vệ trẻ em trong Tin nhắn - Messages, nâng cao khả năng phát hiện nội dung Lạm dụng và xâm hại tình dục ở trẻ em (CSAM - Child Sexual Abuse Material) trong iCloud và cập nhật bảo vệ cho Siri và Tìm kiếm - Search.

Apple nhấn mạnh, việc “bảo vệ trẻ em là một trách nhiệm quan trọng”. Với suy nghĩ đó, công ty khẳng định những nỗ lực này sẽ được “phát triển và mở rộng theo thời gian”.

Tin nhắn - Messages

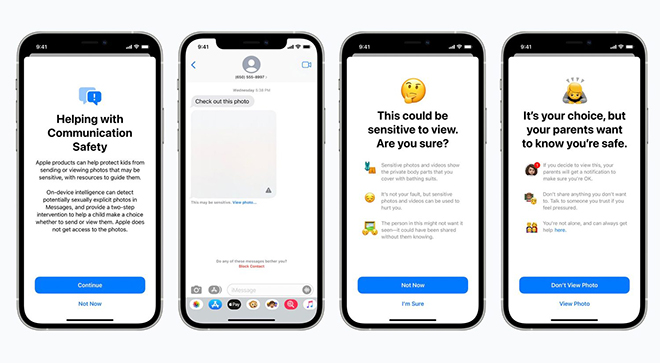

Apple cho hay, khi một đứa trẻ trong Gia đình iCloud – Family iCloud nhận hoặc cố gắng gửi những bức ảnh khiêu dâm, chúng sẽ thấy một thông báo cảnh báo. Cụ thể, các hình ảnh khiêu dâm sẽ bị che mờ và ứng dụng Tin nhắn sẽ hiển thị cảnh báo hình ảnh “có thể nhạy cảm” - may be sensitive. Nếu trẻ nhấn vào “Xem ảnh” – View Photo, chúng sẽ thấy một thông báo bật lên, cho chúng biết lý do tại sao hình ảnh được coi là nhạy cảm.

Ảnh minh họa.

Cửa sổ bật lên sẽ giải thích, nếu đứa trẻ quyết định xem hình ảnh, cha mẹ trong Family iCloud sẽ nhận được thông báo “để đảm bảo rằng bạn ổn”. Cửa sổ bật lên cũng sẽ bao gồm một liên kết nhanh để nhận thêm trợ giúp. Apple cho biết, trẻ em sẽ được cảnh báo trước khi bức ảnh được gửi đi và cha mẹ có thể nhận được tin nhắn nếu đứa trẻ chọn gửi đi, đối với trẻ em dưới 13 tuổi.

Apple giải thích thêm, Messages sử dụng công nghệ học máy – machine learning trên thiết bị để phân tích tệp đính kèm hình ảnh và đưa ra quyết định xem một bức ảnh có nội dung khiêu dâm hay không. iMessage vẫn được mã hóa đầu cuối và Apple không có quyền truy cập vào bất kỳ tin nhắn nào.

Tính năng này sẽ ra mắt “vào cuối năm nay cho các tài khoản được thiết lập gia đình trong iCloud” trong các bản cập nhật lên iOS 15, iPadOS 15 và macOS Monterey. Tính năng sẽ được khởi động trước tại Mỹ.

Phát hiện CSAM

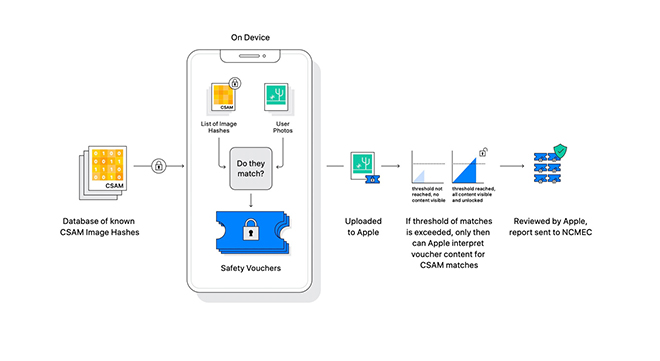

Cùng với đó, “Táo Khuyết” đang công bố các bước mới để phát hiện nội dung CSAM. Tính năng này sẽ cho phép Apple phát hiện các hình ảnh CSAM khi chúng được lưu trữ trong iCloud Photos. Sau đó, Apple có thể báo cáo các trường hợp của CSAM cho Trung tâm Quốc gia về Trẻ em Mất tích và Bị bóc lột (National Center for Missing and Exploited Children), một tổ chức hoạt động như một cơ quan báo cáo toàn diện về CSAM và hợp tác chặt chẽ với cơ quan thực thi pháp luật.

Ảnh minh họa.

Apple liên tục nhấn mạnh, phương pháp phát hiện CSAM được thiết kế với sự lưu ý đến quyền riêng tư của người dùng. Về cơ bản, các hình ảnh trên thiết bị sẽ được phân tích để xem chúng có trùng khớp nào với cơ sở dữ liệu về các hình ảnh CSAM đã biết do Trung tâm Quốc gia về Trẻ em Mất tích và Bị bóc lột cung cấp hay không.

Tất cả các đối sánh đều được thực hiện trên thiết bị nhưng Apple chỉ phân tích ảnh được lưu trữ trong iCloud Photos. Hình ảnh được lưu trữ cục bộ không tham gia vào quá trình này. "Táo Khuyết" cho biết thêm, hệ thống trên thiết bị quan trọng và bảo vệ quyền riêng tư hơn so với quét dựa trên đám mây vì nó chỉ báo cáo những người dùng có hình ảnh CSAM.

Siri và Tìm kiếm - Search

Cùng với đó, Apple cũng đang mở rộng hướng dẫn trong Siri và Tìm kiếm bằng cách cung cấp các tài nguyên bổ sung để giúp trẻ em và cha mẹ luôn an toàn khi truy cập trực tuyến và nhận trợ giúp trong các tình huống không an toàn. Ví dụ: người dùng có thể hỏi Siri về cách họ có thể báo cáo CSAM.

Ảnh minh họa.

Siri và Search cũng đang được cập nhật để can thiệp khi người dùng thực hiện tìm kiếm các truy vấn liên quan đến CSAM. Những biện pháp can thiệp này sẽ giải thích cho người dùng là có hại và cung cấp tài nguyên từ các đối tác để nhận trợ giúp.

Các bản cập nhật cho Siri và Tìm kiếm sẽ ra mắt vào cuối năm nay trong bản cập nhật cho iOS 15, iPadOS 15, watchOS 8 và macOS Monterey.

Động thái trên của Apple nhận được khá nhiều sự đồng thuận từ phía các chuyên gia trong ngành và nhiều quan chức chính phủ.

Ông David Forsyth, Trưởng Khoa Khoa học Máy tính tại Đại học Illinois, Đại học Kỹ thuật Urbana-Champagne nhận định: “Cách tiếp cận của Apple để bảo vệ quyền riêng tư tốt hơn mọi hình thức hiện có. Theo đánh giá của tôi, hệ thống này sẽ giúp tăng lượng người dùng hoặc lưu lượng truy cập trong [CSAM] được tìm thấy; điều này sẽ giúp bảo vệ trẻ em”.