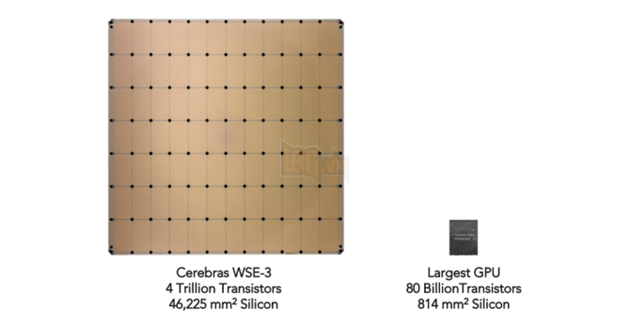

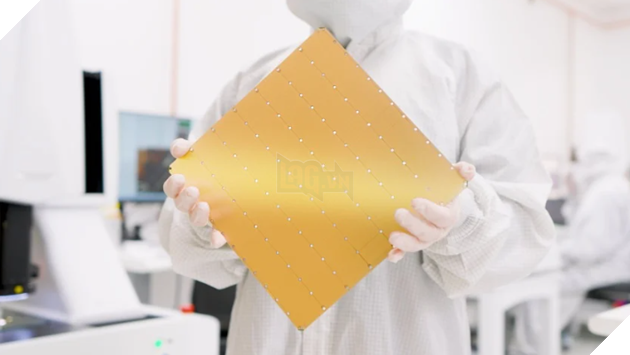

Một công ty khởi nghiệp của Hoa Kỳ, Cerebras Systems, đang tiến hành thách thức sự thống trị của Nvidia trong lĩnh vực GPU dành cho AI bằng cách phát triển và triển khai chip AI riêng biệt của họ. Với chiếc chip Wafer Scale Engine, kích thước tương đương một chiếc iPad, Cerebras đã công bố dịch vụ mới vào thứ Ba, cho phép khách hàng sử dụng công nghệ này để xử lý các tác vụ AI hiệu quả hơn.

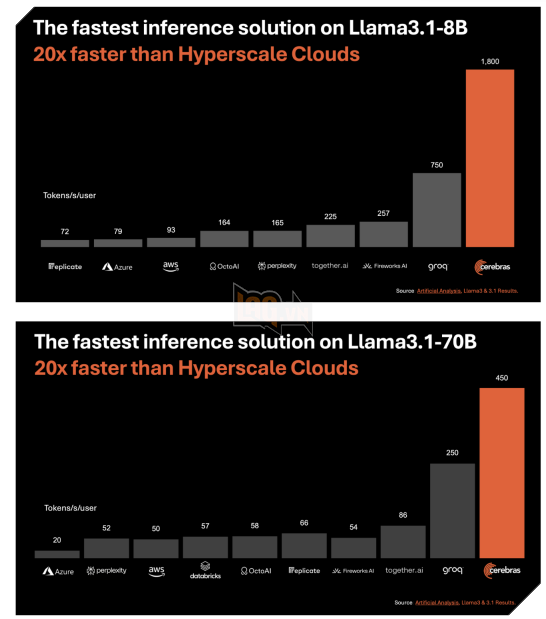

Cerebras tuyên bố rằng công nghệ của họ có thể xử lý các chương trình AI sinh tổng hợp nhanh hơn đến 20 lần so với GPU Nvidia nhưng chỉ với một phần năm chi phí. Đặc biệt, dịch vụ mới của họ, Cerebras Inference, tập trung vào khả năng suy luận của AI, cho phép tạo ra dữ liệu mới như dự đoán từ tiếp theo trong một đoạn văn.

Sử dụng chip này, Cerebras đã hợp tác với Meta để cung cấp năng lượng cho mô hình ngôn ngữ Llama 3.1, đạt hiệu suất với khả năng sản xuất 1.800 token mỗi giây cho phiên bản 8 tỷ tham số và 450 token mỗi giây cho phiên bản 70 tỷ tham số. Điều này cho thấy một sự vượt trội đáng kể so với các dịch vụ đám mây AI khác như AWS của Amazon, Microsoft Azure và Groq, trong đó chi phí cho dịch vụ của Cerebras chỉ là một phần nhỏ so với các lựa chọn dựa trên GPU.

Tuy nhiên, việc so sánh này có phần lệch lạc do Nvidia đã công bố kiến trúc Blackwell mới, hứa hẹn hiệu suất cao hơn nhiều so với H100.

Cerebras đang tìm cách mở rộng quyền truy cập đến chip WSE-3 của mình thông qua việc cung cấp silicon cho các nhà cung cấp dịch vụ đám mây khác, dù giá thành của chip này không hề rẻ, với mỗi hệ thống CS-3 có giá "vài triệu đô la". Điều này khiến giá thành của hệ thống Cerebras đắt hơn đáng kể so với một GPU H100 duy nhất của Nvidia, có thể có giá khoảng 30.000 đô la.

![[Trên Ghế 09] Mua xe điện ở Việt Nam thì sạc tại đâu? [Trên Ghế 09] Mua xe điện ở Việt Nam thì sạc tại đâu?](https://static4.kenhtingame.com/News/Img/04092024/v-template-ep01-169-17253727796581791325930-57-0-1062-1920-crop-17253727982701384419758jpg.jpg)